<span id="9mlez"><optgroup id="9mlez"></optgroup></span>

近日,中國科學院合肥物質院安光所計算機視覺團隊在全景場景圖生成研究方面取得新進展,提出了一種基于CLIP知識轉移和關系上下文挖掘的全景場景圖生成方法,相關研究成果已被信號處理領域的頂級國際會議IEEE International Conference on Acoustics, Speech and Signal Processing (IEEE聲學、語音與信號處理國際會議,ICASSP 2024)接收發表。

全景場景圖生成(Panoptic Scene Graph,簡稱PSG)是當前場景圖生成(Scene Graph Generation,簡稱SGG)領域中的熱門研究方向之一,旨在基于圖像的像素級分割信息,利用所有物體及它們之間的成對關系,進行全景場景圖生成表示。然而,由于訓練數據常呈現長尾分布,當前PSG方法的預測更傾向于高頻和無信息的關系表示(例如“在”、“旁邊”等),導致PSG與實際應用相距甚遠。

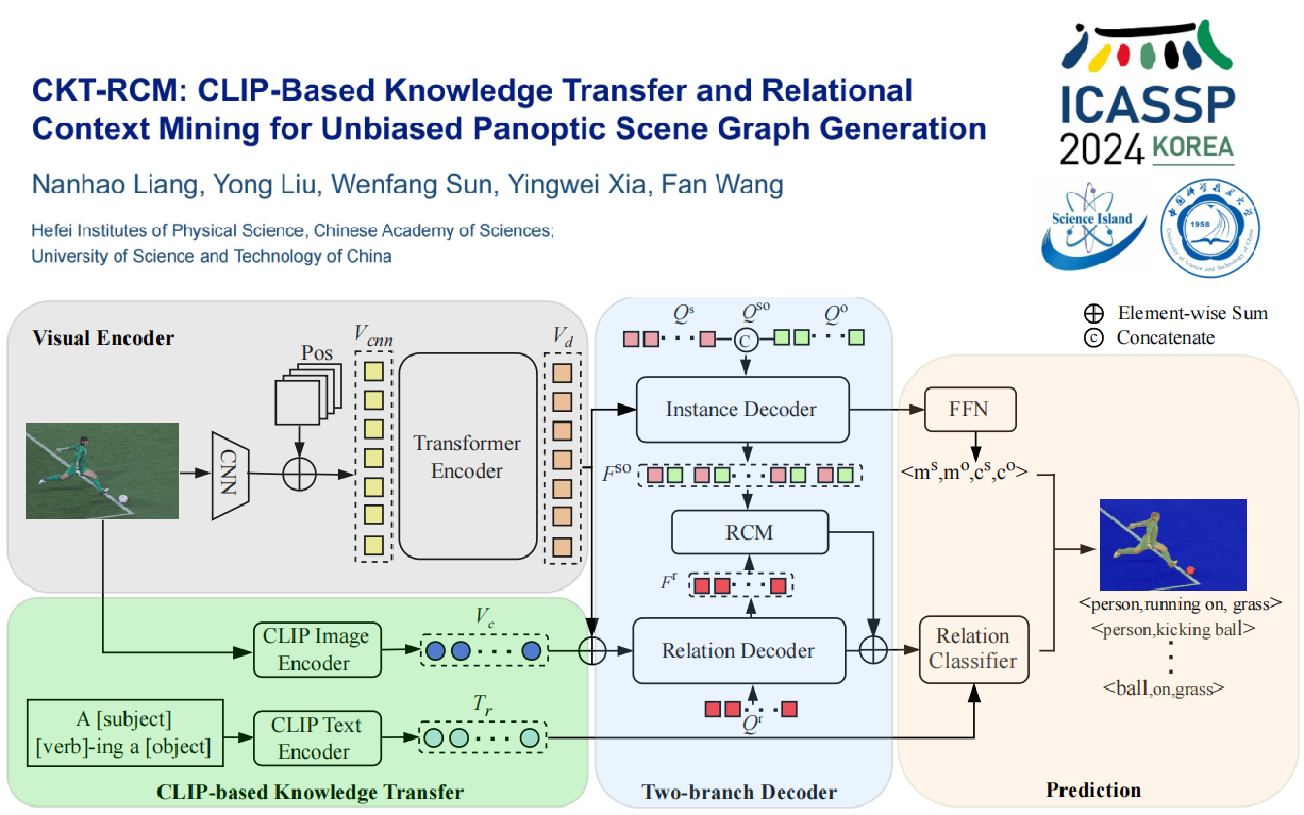

針對上述問題,研究人員受人類先驗知識的啟發,引入了兩個新穎的設計:一是使用預訓練的視覺語言模型來校正數據傾斜性;二是使用條件先驗分布對上下文關系進行進一步的預測質量提升。具體而言,研究人員首先從圖像編碼器中提取與關系相關的視覺特征,并通過從視覺語言模型的文本編碼器中提取所有關系的文本嵌入,從而構建關系分類器。之后,利用主客體對之間的豐富關系上下文信息,通過交叉注意力機制促進上下文的關系精準預測。最后,研究人員在OpenPSG數據集上進行了全面的實驗,并取得了最先進的性能。

博士研究生梁楠昊為論文第一作者,王凡博士后和劉勇研究員為論文通訊作者。該研究工作得到國家重點研發計劃、國家自然科學基金、安徽省博士后研究人員科研活動經費資助項目、合肥物質院院長基金等項目支持。

文章鏈接:https://doi.org/10.1109/ICASSP48485.2024.10446810